Die Ati Hd5870 Und Nvidia Gtx295 Suche^^

#121

geschrieben 29. Dezember 2009 - 14:35

mit markt-strategie hat das ja gar nichts mehr zu tun. die kriegen das ding nicht hin! (glaskugel wieder einpack).

wenn die auf der ces nicht ein kracher-sample präsentieren, bin ich mir so gut wie sicher, dass fermi für den konsumer-bereich eine nullnummer wird.

Anzeige

#122

geschrieben 30. Dezember 2009 - 07:46

NVidia würd ich sowas zu trauen, ich wollt mir zwar nen Femi, wenn er leistungsmäßig was taugt kaufen, eigentlich brauch ich aber keine neue und daher warte ich noch ein paar Monate nach dem Launch

Dieser Beitrag wurde von HeyHey bearbeitet: 30. Dezember 2009 - 07:47

#123

geschrieben 31. Dezember 2009 - 12:49

Die Zyklen sind jetzt aber nichts neues...

Alle 12 Monate eine mehr oder weniger neue Architektur (ausbauen sei natürlich erlaubt)

Daran anschließend nach 6 Monaten nochmal ein sog. "Refresh".

Genügend Geldbesitzer gibt es ja, die jeden Millimetersprung nachvollziehen müssen...

Dieser Beitrag wurde von ...but alive bearbeitet: 31. Dezember 2009 - 12:50

#124

geschrieben 31. Dezember 2009 - 15:05

trotzdem würd ichs persönlich so ein Vorgehen mehr als unfair finden,

wenn der Femi bei Spielen eh nicht so gut abschneidet, dann kann man meiner Meinung von ausgehen, dass die so schnell wie möglich versuchen, ihre komplett neue Architektur auf den Markt zu bringen, aber was solls, ich brauch noch keine neue und daher geh ich auf nochma sicher

#125

geschrieben 31. Dezember 2009 - 15:31

Zitat

Das hat keiner gesagt. Ich denke, er wird sogar besser sein als die HD5870, schlichtweg weil Nvidia da ein Monster an Chip auffährt. Aber gerade das ist das Problem. Sie haben dann zwar den schnellsten und HPTC-geeignetesten (was für ein Wort!) Chip, aber der wird naturgemäß entsprechend kosten.

Wenn ich ein Geophysiker o. Privatangeber wäre, würde ich mir dieses Teil wahrscheinlich sofort in den HPTC-Fuhrpark stellen, aber so verfehlt Nvidia mit diesem Ding den Markt.

ATi hat den Heimanwendermarkt eingehend analysiert (dieselben Ergebnisse müsste Nvidia auch vorliegen haben) und den richtigen Schluss gezogen, als es an die Designphilosophie hinter dem RV700 ging:

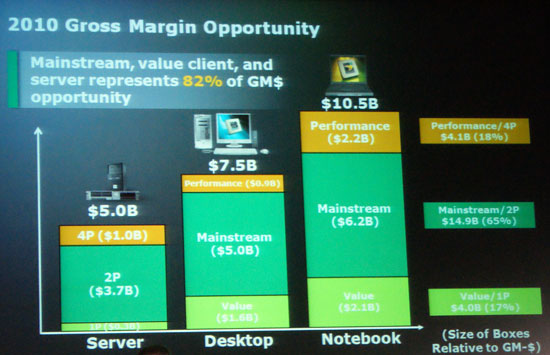

Der allergrößte Teil des Kuchens ist NICHT im High-End zu gewinnen, sondern im magischen Preis-Delta von $199-$299 (auch bekannt als Mainstream-Markt).

Ja, so ein Fermi kostet dann wahrscheinlich weit jenseits der $500, aber die absolute Anzahl der Käufer ist verschwindend gering. Eine HD4850 kostete zu ihrer Einführung jedoch nur $199 und die Gesamtzahl der in diesem Preissegment verkauften Einheiten war um ein vielfaches höher als bei den teuren High-End-Chips.

Schauen wir in der Geschichte der GPUs zurück, dann ist es exakt dieses Muster, das dafür sorgt, dass eine Firma entweder an die Spitze stößt oder untergeht.

Die Billigst-TNT-GPU mit integrierter 2D/3D-Funktionalität hat 3DFX das Rückgrat gebrochen, nicht die High-End-Geforce...

Blöderweise hat Nvidia aus seinen Anfangstagen nicht gelernt... was sie da jetzt mit Fermi produziert haben ist nichts anderes als eine Voodoo 5000... sie produzieren damit am Interesse des Marktes vorbei. 80% der Endkunden erwartet von einer GPU seit eh & je "schnell + günstig" und eben NICHT "10% schneller für 100% Aufpreis"...

Stattdessen werden von Nvidia jetzt HPTC-Kunden umschwärmt in der vagen Hoffnung, dass sich mit diesen derselbe Umsatz generieren ließe, den eine Mittelklassengranate wie die HD4870/GTX260/HD5770 produziert...

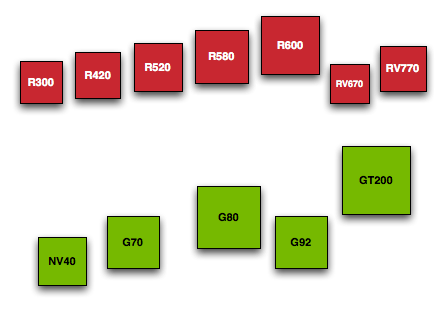

Hinzu kommt, dass ATi da einfach die bessere Design-Philosphie vorweisen kann.

Sie haben einen kleinen Chip, der im Notfall einfach verdoppelt wird, um im Laberzirkus Hi-End mitsabbeln zu können... Nvidia hingegen hat einen Monolithen, der, wenn man ihn denn auch noch verdoppelte, ohne weiteres die Stromversorgungsspezifikationen von PCI Express sprengt...

Richtig teuer wird es dann, wenn dann noch eine zusätzliche Architektur für den so wichtigen Mainstreammarkt produziert werden muss...

http://www.theinquirer.net/inquirer/news/1...00-architecture

Dieser Beitrag wurde von ...but alive bearbeitet: 31. Dezember 2009 - 16:03

#126

geschrieben 31. Dezember 2009 - 16:12

die ersten teslas haben einen teil deaktivierte shaderprozessoren. das lässt den rückschluss auf thermische und verbrauchsprobleme zu, denn die max. leistungsaufnahme ist dennoch mit 225W angegeben.

ein strukturelles problem, die kompletten 512 shader zu betreiben, sollte der chip eigentlich nicht haben. gerade auf eine hohe integration und skalierbarkeit hatte nvidia bei dem chip gesetzt: es sollte einer der wesentlichen vorteile gegenüber dem ati-pendant sein, bei dem die ansteuerung und ausnutzung jedes fünften streamprozessors der shadereinheiten problematisch bzw relativ aufwändig ist und die noch beim catalyst 9.11 brachlagen.

ebenso verdichten sich die hinweise, dass sich der consumerchip G100 nicht wesentlich vom 'original'- fermi unterscheiden wird. auch das ist leider ein hinweis sowohl auf fertigungstechnische probleme als auch auf ein zumindest teilweises scheitern der geplanten skalierbarkeit.

um die angestrebte theoretische shaderleistung (+15% ggü dem RV870 bei double precision) dennoch zu erreichen, muss nvidia nun gehörig an der taktschraube drehen und erreicht diese erst bei 1,4 GHZ.

was dieser theoretische wert in der praxis bedeuted, steht auf einem anderen blatt. und der ati-chip taktet mit 850 mhz...

wie sich die materialisierung des fermi zu seinem tape-out verhält, kann man ganz gut an diesem c't-artikel vom oktober nachvollziehen.

interessant finde ich auch, dass die jetzt immer offensichtlicheren probleme keineswegs überraschend kommen. wie ...but alive oben darlegt, waren sie durchaus absehbar, und auch die fachwelt hat immer wieder gespannt auf nvidias lösungen zu den anzunehmenden problemen gewartet.

noch schlimmer: dieses monster lässt sich eigentlich nicht mehr weiterentwickeln...

Zitat

schlimmstenfalls stimmt das wirklich.

Dieser Beitrag wurde von klawitter bearbeitet: 31. Dezember 2009 - 16:24

#127

geschrieben 31. Dezember 2009 - 16:34

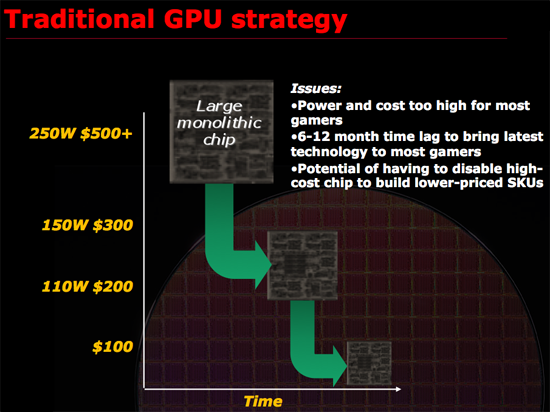

Das erste Bild zeigt Nvidias Strategie. Sie haben nichts geändert. Entwickeln einen Big Chip für 20% des Marktes und dann dürfen die Ingenieure zusehen wie sie ihn kleinkriegen (oder eben nicht - sonst stünde der GT300 bereits im Laden).

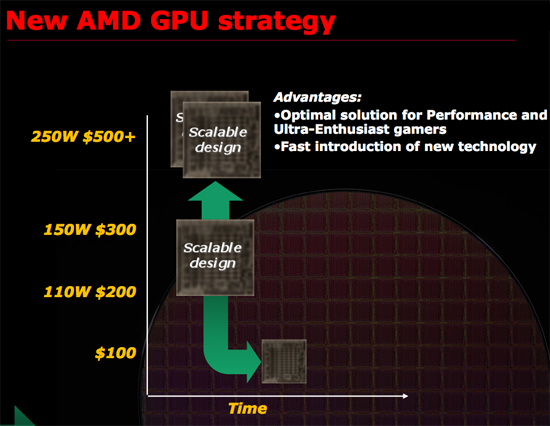

ATi hat umgeschwenkt und setzt auf eine Strategie der goldenen Mitte (Aristoteles); siehe Bild "New AMD GPU strategy". Sie entwickeln zuerst den Chip für den "Sweet Spot" (= $199 bis $299, i.e. HD5870 + HD5850) und zielen damit direkt auf die strategisch relevanten 66% des möglichen Umsatzes auf dem Gesamt-GPU-Markt ab. Offensichtlich hat da mal jemand gründlich nachgedacht. Besagter Mainstream-Chip lässt sich relativ simpel verdoppeln, womit dann Hi-End abgedeckt wäre (i.e. HD5970) und wahrscheinlich auch sehr viel einfacher schrumpfen, wie man an den beiden erfolgreichen HD5770 + HD5750 sehen kann.

Wenn allerdings bereits die Multi-Die GPU HD5970 in Leistungskrachern wie Furmark automatisch drosselt (sic!), weil sie dermaßen viel Strom frisst, wie soll da erst Nvidia ihren Monsterchip auf eine 2x-GPU-Lösung packen können?

Fazit: Nvidia hat gepennt, Raider heisst jetzt Twix und die Voodoo 5000 Fermi...

Geschichte scheint sich tatsächlich zu wiederholen.

Dieser Beitrag wurde von ...but alive bearbeitet: 31. Dezember 2009 - 22:31

#128

geschrieben 31. Dezember 2009 - 16:39

Zitat (...but alive: 31.12.2009, 16:34)

Zitat (...but alive: 31.12.2009, 16:34)

bitte pinnen

#129

geschrieben 01. Januar 2010 - 16:49

Zitat (klawitter: 31.12.2009, 16:12)

Zitat (klawitter: 31.12.2009, 16:12)

Schon lange lassen sich hingegen die extremen Treiber Probleme mit den ATI Grafikkarten nicht mehr verleugen. Während Nvidia vorzügliche Treiber für anständige Hardwarebeschleunigung für FreeBSD, Linux, (Open)Solaris und Windows liefert und auch immer wieder frische "legacy" Treiber für ältere Grafikkarten veröffentlicht, sieht es da bei ATI finster aus.

So wird auch klar, wie ATI seine Produkte billiger anbietet, es gibt nur wenig, oder gar keine anständigen Treiber dafür, so, dass aus der ATI Hardware wenig nutzen zu ziehen ist. Wegen der desolaten Treibersituation bei ATI sind selbst viel kostengünstigere Intel Onboard Grafiklösungen meist die bessere Wahl und vor allem langfristig zuverlässiger, weil ATI derart misserable Treiberunterstützung bietet.

Dieser Beitrag wurde von Internetkopfgeldjäger bearbeitet: 01. Januar 2010 - 17:12

#130

geschrieben 01. Januar 2010 - 18:15

nvidiatreiber aus 2004

ati-treiber aus 2006,

der letzte linuxtreiber z.b. für die igp xpress200 stammt aus märz 2009.

die für den von dir angesprochenen userkreis imho eher interessanten fire-karten incl der alten gl-modelle werden nach wie vor supportet.

so ganz kann ich die dramatik nicht nachvollziehen. natürlich hast du recht, dass nvidia das aus sicht von unix-/derivat-usern das weit sympatischere treiber-modell hat.

allein, es betrifft 1 oder 2% aller user (ich schätze eher weniger), denen man dann auch dringendst zu einer nvidia-karte raten sollte.

die ökonomische (und ingeniöse(?), q. e. d.) irrfahrt, auf die sich nvidia mit seinem neuen chip begeben hat, hat damit allerdings rein gar nichts zu tun. auch nicht die tatsache, dass nvidia seit langem aufgrund des designs deutlich kostenintensiver produzieren muss.

die bedeutung der 'sparten'-treiberfrage zu den hier behandelten sachverhalten kann ich nicht erkennen. zumal sich schon aus der anlage des forums ergibt, dass es hier im wesentlichen um belange von windows-usern im consumerbereich geht.

#131

geschrieben 01. Januar 2010 - 19:58

es mag zwar sein, dass die teueren dicken Grafikkarten gerne von Jugendlichen gekauft werden würden, die damit gerne Crysis & Co spielen wollen, aber gerade im professionellen Umfeld ist mehr Geld dann auch tatsächlich vorhanden, um sich den Wunsch nach einer leistungsstarken Grafikarte auch wirklich zu erfüllen. Auch ist da (normalerweise) die Weitsicht vorhanden, darauf zu achten sich nicht unnötig selbst zu knebeln.

Spätestens kommt sonst die Reue, wenn die Daddelkiste in eine Workstation ausgebaut werden soll, durch ein Upgraden auf ein Unix. Irgendwo mit anwachsendem Lebensalter will man ja nicht nur noch ausschließlich grenzdebil Crysis weiterdaddeln.

Dann bekommen ATI Käufer meist Pipi in den Augen.

Hunderte von Euros für die Grafikkarte ausgegeben, aber derjenige, der auch nur eine Intel Onboard Grafiklösung hat, kann diejenigen mit den ATI Graikkarten auslachen.

Diese ganze hypotetische Laberei und Raterei, ob dieses oder jenes Feature "besser" sein mag,

tritt völlig dahinter zurück, ob das Stück Hardware für verdammt viel Kohle überhaupt richtig funktioniert. Bei ATI ist es so, dass eigentlich nur Windows teilzeittreiberunterstützt wird.

Nicht mal Windows Benutzer kommen aber in den Genuss von Treibern für ihre mit teuer Geld bezahlte Grafikkarte, wenn ATI der Meinung ist, die wäre zu alt: http://winfuture.de/news,45693.html

Dann nur noch ein frisches Windows Release und schon ist Ende im Gelände.

Erinnert irgendwie fatal an Creative mit seiner Soundkartenpolitik,

durchaus tolle Hardware, die durch beschissene Firmenpolitik und genauso schlechte

Treiberpolitik geradezu mutwillig unbrauchbar gemacht werden. Ja, schade um die Hardware.

#132

geschrieben 01. Januar 2010 - 20:41

"Teilzeittreiberunterstützt", nennt das der Linux-Troll.

Die 2x selbst verlinkte News auch mal gelesen?

Da steht, dass ältere Karten nicht mehr jeden Monat, sondern stattdessen jeden dritten Monat ein Treiberupdate erhalten... und gleich brennt Rom ab...

Ehrlich, mir kommen auch gleich die Tränen, wenn der arme Linux-User Crysis Warhead natürlich nur aufgrund der schlechten Treiber mit seiner 7 Jahre alten Radeon 9600 nicht spielen kann.

Hallo? Realitätscheck?

Was brauche ich einen brandaktuellen Treiber für eine Grafikkarte, die aktuelle Spiele a) eh nicht packt, was b) auch noch dadurch ad absurdum geführt wird, dass aktuelle Spiele selten zufriedenstellend unter Linux laufen, falls denn überhaupt:

http://www.anandtech...doc.aspx?i=3700

Zitat

Crysis? + Leistungsstarke Grafikkarte? + Professionelles Umweld?

Reden wir hier etwa von Pro-Gamern? Was will ein Counterstrike

Zitat

Natürlich. Nahtlos vom Counterstrike-Rul0r zum Pro-Programmierer...

Tip: Ich würde den Satz nicht mit "Spätestens.." beginnen, sondern besser mit "Es war einmal.."

Zitat

Das hier durchscheinende Welt- und Menschenbild nimmt langsam Konturen an (ich teile zwar die Meinung, dass es sich bei Crysis in Wirklichkeit um eine Nvidia-Vegetationsdemo handelt), frage mich allerdings, ob jemand der Linux benutzt und den ganzen Tag vor grafiklastigen Computerspielen sitzt, deswegen ein besserer Mensch als sein Crysis-spielendes-Windows-Pendant ist...

Zitat

Selbst mit der glorreichen Nvidia-Hardware sieht's doch eher mau aus im Bereich aktuelle Spiele & Performance unter Linux:

http://www.anandtech...doc.aspx?i=3700

Und wo ist das Problem?

Entweder nutzt Du den ATi-OpenSource-Treiber oder - wenn das partout nicht läuft und Du weisst, dass es nur mit Nvidia geht, kaufste eben Nvidia, falls Du Dir den Frickelkrampf mit aktuellen Spielen + Linux unbedingt antun willst...

Dieser Beitrag wurde von ...but alive bearbeitet: 01. Januar 2010 - 20:51

#133

geschrieben 01. Januar 2010 - 21:05

du hast ja nicht unrecht, wobei ich es bei weitem nicht so kategorisch sehe. zum einen altert harware auch unter unix. zum anderen ist eine workstation nicht zwingend auf unix angewiesen. zumal der begriff erst mal nichts anderes als einen besonders soliden rechner zum produktiven oder wissenschaftlichen einsatz bezeichnet. zur leistungsfähigkeit an sich sagt er nichts, das wird aber gerne hineininterpretiert.

z.b. für eine cad-workstation brauche ich in vielen balangen nur einen bruchteil der rohleistung eines durchschnittlichen, heutigen spielrechners, aber eine höhere rechnerische genauigkeit und zugriff auf einige opengl-befehle, die mir bei consumerkarten versagt bleiben. dabei haben viele softwarehersteller im bereich cad ihre unix-unterstützung in den vergangenen (10!) jahren nach und nach eingestellt. technisch gesehen schade, wirtschaftlich aber nachvollziehbar.

wenn man mit unix arbeitet, weiss man doch eigentlich vorher, dass man nicht zur vorrangigen zielgruppe von ati gehört. entsprechend nicht vorhanden ist ja auch der marktanteil von ati in diesem segment.

die diskussion hier geht doch um die frage, ob nvidias hauptaugenmerk auf den professionellen markt mit dem gewählten weg nicht zum einbruch im consumerbereich führt oder ob nvidia seine sehr ehrgeizigen ziele schaffen wird. das ist für sich genommen ein technisch extrem spannendes thema, und es fokussiert sich hier eben auf den bereich, den du massgeblich jugendlichen zusprichst.

btw: z.b. die wildesten online-zocker sind frauen zwischen 30 und 45, so viel wie die zocken nicht mal 15jährige pubertanten

die fragen, die du aufwirfst, wären in einer diskussion zu fire vs. quadro sinnvoll angebracht, die faireweise noch um matrox zu erweitern wäre. eine aus einer so speziellen perspektive beleuchtete frage würde ich aber ohnehin nicht in diesem forum diskutieren

wichtig ist einem professionellen anwender einzig, dass die verwandte hardware vom software-hersteller zertifiziert ist, und die wird gekauft bzw. vom systemhaus entsprechend konfiguriert. im verhältnis zu den investitionen in software, maintenance und support sind die hardwarekosten ohnehin eher geringfügig. insofern ist das tal der tränen dann doch eher theoretischer natur...

(und ein prfessioneller adobe-cs-user ist btw mit windows (64) und ati radeon derzeit bestens bedient)

kurzum: ich denke, dass deine überlegungen für >99% aller radeon-käufer und genauso >99% aller geforce-käufer mit gleichem impetus keinerlei relevanz besitzen.

für 'freizeit'-entwickler mag das natürlich anders aussehen... aber auch die machen diesen fehler sicher nur einmal.

ps:

du vergleichst doch auch nicht den kofferaum eines 911 mit einem sattelschlepper, oder?

Dieser Beitrag wurde von klawitter bearbeitet: 01. Januar 2010 - 21:15

#134

geschrieben 01. Januar 2010 - 21:41

Zitat (...but alive: 01.01.2010, 20:41)

Zitat (...but alive: 01.01.2010, 20:41)

Sag mal, bist du etwa noch von Silvester etwas angeschickert?

Wie kommst Du denn auf "Linux-Troll"?

Schau noch mal genau hin, da auf den Avatar, das ist gar kein dicker Pinguin.

Für Linux gibt es Hardwarbeschleunigende properitäre ATI Treiber

auch wenn die von ATI nicht allzu viel taugen, insbesondere gerne zu Instabilität führen

oder gar nicht erst zum aktuellen Kernel und/oder X-Server passen.

Schau noch mal genau hin, was es hingegen bei Nvida für eine Auswahl

von vorzüglichen Hardwarebeschleungten Treibern fernab von Windows gibt:

http://www.nvidia.com/object/unix.htm

Ganz zu schweigen von den NVIDIA Quadro Grafikkarten, für die professionelle Anwendung.

Das schöne ist ja, dass die Nvidia Unix Treiber auch gleich noch zertifiziert sind.

Und bei Intel sieht es noch besser mit der Treiberverfügbarkeit aus.

Davon können ATI Käufer noch lange träumen.

Was aber das Spielen betrifft, unter Windows, denn ja, auch ich fröne hin und wieder

gerne noch mal diesem alten Laster mit Genuss, da fährt man mit Nvidia einfach nur vorzüglich.

Freunde von mir, die übrigens trotz fortgeschrittenen Alters immer noch völlig dem Daddelkram

unter Windows verfallen sind, hatten es schon mal mit ATI versucht und haben ein vernichtendes Urteil gefällt.

Die sind sind dann schleunigst wieder reuig zu Nvidia zurückgekehrt,

da die Nvidia Grafikkarten einfach viel unproblematischer

die Spiele zum rennen brachten, als die ATI Grafikkarten.

#135

geschrieben 01. Januar 2010 - 22:10

des weiteren riecht es langsam nach kloparole. zeit, den diskurs seinem schicksal zu überlassen.

(freebsd-nerd attitüde und 'xy rulez - freunde ham gesagt'-sprüche wirken in kombination irgendwie wenig überzeugend

Dieser Beitrag wurde von klawitter bearbeitet: 01. Januar 2010 - 22:13

Hilfe

Hilfe

Neues Thema

Neues Thema Antworten

Antworten

Nach oben

Nach oben