Zitat (klawitter: 01.01.2010, 22:10)

Zitat (klawitter: 01.01.2010, 22:10)

Also ich war es nicht gewesen, der den Thread in dem es ursprünglich

um Beschaffungsmöglichkeiten für die gerade aktuellen Top Modelle von ATI und Nvidia ging,

in eine rituellen Rant "ATI vs. Nvidia" ausarten ließ.

Habe nur aufgezeigt, das es da einen Pferdefuß bei ATI Grafikkarten gibt

die desolate Treiberlage, die an Creative bei den Soundkarten erinnert,

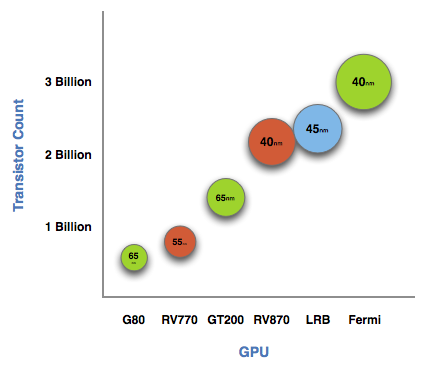

nachdem über noch gar nicht auf dem Markt befindliche Produkte von Nvidia

spekulativ hergezogen wurde. Was mich irgendwie an 10-Jährige erinnerte

die ein Kartenspiel haben, worauf irgendwelche Autos mit den Fahrzeugdaten aufgedruckt sind

und darum spielen, wer mehr Km/h, PS usw. hat, auch wenn der Führerschein

noch in weiter ferne ist. Ich erinnere mich da an Kindertage.

Der Threat Eröffner wollte doch bloß wissen, wo er entweder eine ATI HD 5870

oder eine Nvidia GTX 295 herbekommen kann:

Die Ati Hd5870 Und Nvidia Gtx295 Suche^^

Da ist aber der Thread schon auf der ersten Seite in den rituellen ATI vs. Nvidia Rant abgerutscht.

Tja, was also die Liefermöglichkeiten angeht, ich selbst habe mich dann einfach

mit einer Nvidia GTX 260 begnügt, nachdem ich nichts dickeres bekommen habe.

Hilfe

Hilfe

Neues Thema

Neues Thema Antworten

Antworten

Nach oben

Nach oben