gleich vorweg: Ich habe keine Daten verloren, und will auch keine Daten wiederherstellen!

Vorwort:

Meine alte 2TB HDD war zum Brechen voll, daher habe ich mir eine neue 4TB Festplatte gegönnt:

Seagate Backup Plus Desktop STCA4000200

Da mein Notebook nur USB2.0 unterstützt, dafür aber eine ESATA-Schnittstelle besitzt, nutze ich schon seit 2009 immer ESATA für meine externen Festplatten.

Leider gab es die 4TB Festplatte nur mit USB3.0. Daher habe ich sie in folgendes Gehäuse umgebaut:

Fantec DB-ALU3e

Meine restliche Soft- und Hardware steht in meiner Signatur.

Problem:

Ich habe meine knapp über 2TB Daten auf die Festplatte kopiert, ohne Probleme.

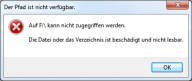

Nach etwa 5mal an und abstecken der Festplatte (gewöhnliche Nutzung) konnte ich plötzlich nicht mehr auf einen Ordner zugreifen. Kurz danach auch auf die restlichen Ordner nicht mehr. Dann auf die ganze Platte nicht mehr:

Selbstverständlich habe ich es gleich mit Checkdisk versucht, auch, als es noch ein Ordner war, der nicht ansprechbar ist. Das Problem ist, das sich Checkdisk aufhängt. Ich habe es schon eine nacht durchlaufen lassen, aber es bleibt immer stehen.

Ich habe dann nochmal die Festplatte beim Bootvorgang checken lassen, weil man da mehr sieht.

Da wird mir in etwa folgendes angezeigt:

Im Index "$I30" für die Datei "5" wurde ein Fehler gefunden.

Der Fehler in Datei ... wird behoben.

Weiter kommt Checkdisk aber nicht!

Mit der Freeware CheckDisk 1.3 erhalte ich folgende Ausgabe:

checkDisk will work now with drive: F: F:\ Volume Label: JB-EXT4TB, File System: NTFS Die Volumebezeichnung lautet JB-EXT4TB. CHKDSK überprüft Dateien (Phase 1 von 3)... 241920 Datensätze verarbeitet. Dateiüberprüfung beendet. 0 große Datensätze verarbeitet. 0 ungültige Datensätze verarbeitet. 0 E/A-Datensätze verarbeitet. 0 Analysedatensätze verarbeitet. CHKDSK überprüft Indizes (Phase 2 von 3)... Im Index "$I30" für die Datei "5" wurde ein Fehler gefunden. Im Index "$I30" für die Datei "5" wurde ein Fehler gefunden. Im Index "$I30" für die Datei "240299" wurde ein Fehler gefunden. Im Index "$I30" für die Datei "240299" wurde ein Fehler gefunden. [~~~usw~~~] Im Index "$I30" für die Datei "241852" wurde ein Fehler gefunden. Im Index "$I30" für die Datei "241852" wurde ein Fehler gefunden. 263198 Indexeinträge verarbeitet. Indexüberprüfung beendet. Fehler gefunden. CHKDSK kann im schreibgeschützten Modus nicht fortgesetzt werden. Check Disk Callback: 32 Check Disk: Unable to Finish Laufwerk kann nicht überprüft werden, wiederholen Fehler mit Laufwerk: F

Ich habe jetzt etwa zum 5. mal meine Daten auf die Festplatte kopiert, aber jedes mal, nachdem ich alle Daten drauf hatte, und sie gerade anfange normal zu nutzen, kommt es wieder zu diesem Fehler.

Da Checkdisk sich aufhängt, bleibt mir nur eine Neuformatierung.

Zur Festplatte:

- 4TB NTFS Partition

- GPT

- 16k Cluster

- Cache aktiv, da ohne die Festplatte deutlich langsamer ist, auch bei große Dateien.

- Betrieben über ESATA

- Das Externe Gehäuse überträgt die Daten per ESATA direkt, Im Gerätemanager wird die Festplatte, und nicht das Gehäuse erkannt, der Datentransfer wird nicht per LED am externen Festplattengehäuse angezeigt. Daher halte ich das Gehäuse als Ursache, für sehr unwahrscheinlich. Trotzdem versuche ich es jetzt noch einmal mit einem anderen Gehäuse.

Was ich bis jetzt versucht habe:

- Festplatte umgetauscht, neue macht wieder die gleichen Probleme

- 4kB und 16kB Cluster

- zwei Partitionen mit je unter 2TiB

Was ich noch versuchen will (es dauert immer ein paar Tage, die Daten neu aufzuspielen)

- anderes externes Gehäuse verwenden (wohl wenig Aussicht auf Erfolg)

Was ich von euch will

- Gründe und Ursachen

- Lösungen

Nachwort:

Ja, ich melde meine Festplatten nicht immer mit "Hardware sicher entfernen ab". Allerdings habe ich das noch nie gemacht, auch nicht mit meinen anderen Festplatten mit größen bis 2TB, und nie gab es solche Probleme. Es macht auch keinen Sinn in Zukunft darauf zu achten, denn irgendwann vergesse ich es doch, bewusst, oder unbewusst. Und dann ist die Kacke am Dampfen, wenn ich dann tatsächlich Daten drauf hatte, die ich noch nicht woanders gesichert hatte. Ich muss mich darauf verlassen können, dass meine Daten sicher auf der Festplatte sind.

Grüße

Strom

Hilfe

Hilfe

Neues Thema

Neues Thema Antworten

Antworten

Nach oben

Nach oben